Сегодня в очередной раз я хотел бы затронуть тему поиска кеев. Ведь хороший кей – это хороший траф, а хороший траф – деньги. Я бы хотел рассказать об одном довольно старом методе сбора кеев, на который последнее время мало кто обращает внимание. Я расскажу о сборе кеев со скриптов веб-статистики (как продолжение моей же темы о сборе кеев со счетчиков).

Сегодня в очередной раз я хотел бы затронуть тему поиска кеев. Ведь хороший кей – это хороший траф, а хороший траф – деньги. Я бы хотел рассказать об одном довольно старом методе сбора кеев, на который последнее время мало кто обращает внимание. Я расскажу о сборе кеев со скриптов веб-статистики (как продолжение моей же темы о сборе кеев со счетчиков).

Для тех кто не совсем понимает о чем речь, я сделаю лирическое отступление. Мы говорим о скриптах, которые ставятся к себе на сервер и собирают и обрабатывают всю статистику там же, без участия сторонних сервисов и ресурсов. Очень часто они идут в комплекте с какой нибудь панелькой, в следствии чего и являются довольно распространенными.

Начнем, пожалуй, с самого популярного скрипта для статистики – Webalizer (многие знают его по периоду, когда реф-спам еще давал результаты). Информация из Википедии http://ru.wikipedia.org/wiki/Webalizer по этому вопросу: «Вебалайзер (англ. Webalizer) — прикладная программа, распространяемая под лицензией GPL, на основе файлов регистрации (например, access.log) событий веб-сервера генерирующая HTML-страницы со статистикой о работе веб-сайта.»

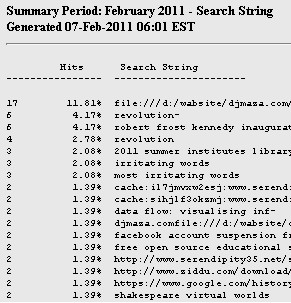

Webalizer создает страницы с различными данными. Нас, на данном этапе, интересуют страницы с поисковыми запросами. Вот пример такой страницы http://www.serendipity35.net/stats/search_201102.html , на которой мы можем увидеть поисковые запросы для данного сайта:

В первой колонке мы видим количество поисков за текущий месяц , во второй – процент от общего числа и в третьей — сам кей. Вот и все можно изучать кеи. Остановимся поподробнее на поисках подобных ресурсов. За месяц отвечает параметр в урле после search — search_YYYYMM.html – вместо YYYY ставим год, вместо MM – месяц. Комбинируем наличный во всех футерах данного скрипта текст «Generated by Webalizer » и параметр урла search_YYYYMM.html , получаем запрос для парсинга гугла.

«Generated by Webalizer» inurl:search_201101.html

Можно и нужно комбинировать запросы с разными словами, языками, региональной выдачей гугла, временными отрезками индексации – все зависит от конкретно ваших целей. А вот другие запросы для парсинга:

inurl:search_ YYYYMM.html inurl:/stats

inurl:search_ YYYYMM.html inurl:/webalizer

«Generated by Webalizer» Search String

«Generated by Webalizer» intitle:»Usage Statistics for »

Также мне нравится такой метод парсинга:

1. Идем на http://www.google.com/imghp — поиск гугла по картинкам.

2. Вбиваем «Daily usage for » filetype:png

3. Получаем скрины статистики.

И легко получаем такую страницу http://houdegbeuniversity.org/webalizer/usage_201012.html#TOPSEARCH (просто переходим к корню папки, в которой лежит картинка). Вот и все по парсингу. Далее я обрабатывал информацию скриптом, которому давал файл со списками линков по одному на строку:

http://www.ecmjournal.org/stats/search_201101.html

http://stats.nofrag.com/nofrag/search_201101.html

http://www.onaway.org/stats/search_201101.html

Скрипт со всех собирал кеи. Скачать скрипт вы можете по этой ссылке. На папку data и файлы в ней ставим права 777, в links.txt ставим линки, как указано выше и в results.txt получим кеи. В самом скрипте есть одна настройка, в линии №9: $min_hits=10; # Minimum Hits — здесь ставим минимальное количество поисков в месяц. Если поставить 0 то скрипт соберет все кеи со всех страниц, если 10 – то только те, по которым заходили 10 и более раз. Вот и все по этому сервису. Пойдем дальше.

Второй по популярности (мое мнение, не знаю офф. данных) — Awstats. Этот скрипт дает две страницы с кеями – одна с однословными keywords и вторая с фразами keyphrases. Например:

http://graciaaudio.com/awstats/cgi-bin/awstats.pl/awstats.pl?framename=mainright&output=keyphrases

http://graciaaudio.com/awstats/cgi-bin/awstats.pl/awstats.pl?framename=mainright&output=keywords

Запросы для поиска (парсинга):

«Advanced Web Statistics» inurl:stats/ awstats

inurl:awstats.pl «Keyphrases used on search engines»

«Show content of Log Files (5000 first lines):» intitle:»Statistics for»

inurl:awstats.pl «Keyphrases used on search engines»

Данный скрипт имеет несколько языковых версий. Есть и переключатель на страницах:

И это тоже можно и нужно использовать при парсинге добавляя к запросам по признаку в урлу еще и языковые варианты. Например, так:

«Suchausdrucke (Suchmaschinen)» inurl:awstats

«Phrases cles de recherche» inurl:awstats

Т.е. цель такая же – получить кучу страниц с отчетами по кеям и потом собрать их для работы по НЧ или анализировать и использовать для работы по СЧ и ВЧ. Опять же прилагаю скрипт, принцип работы абсолютно такой же как и у первого. Дальше кратко о подобных вариантах.

WebLog Expert.

Поскольку функции абсолютно те же и цели тоже, даю только запросы для парсинга и примеры страниц.

Общая стата — http://www.franktronics.net/webstat/

Поисковые фразы разбиты по поисковым системам — http://www.franktronics.net/webstat/Referrers.htm#Engines_and_Phrases

Просто кеи — http://www.franktronics.net/webstat/Referrers.htm#Search_Keywords

Парсим ресурсы по запросам:

inurl:webstat/Referrers.htm

«Daily Search Keywords» inurl:webstats

inurl:webstats intitle:»Report for »

Nihuo Web Log Analyzer.

Кеи находятся на таких страницах:

http://www.themayfair.com/Reports/week/201031/Top_Search_Keywords.html

http://www.asian-bamboo.com/Analysis/daily/20100102/Top_Search_Keywords.html

http://legis.state.va.us/webstats/public/April2010/Top_Search_Keywords.html

Запросы для парсинга:

inurl:Top_Search_Keywords.html

inurl:stats/2010/daily/

inurl:stats/2010/daily/

inurl:stats/2010/week/

Не на всех сайтах сразу можно попасть на страницу кеев, поэтому после парсинга переходите в корень и уже там осуществляйте навигацию. Например, так http://www.asian-bamboo.com/Analysis/Top_Search_Phrases.html можно получить список всех Top запросов для сайта.

Таким запросом «Daily Search Phrases filetype:png» в http://www.google.com/imghp (поиск гугла по картинкам) можно найти различную открытую статистику.

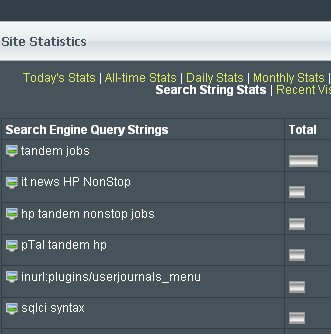

Есть также и не совсем полноценные скрипты, а адаптированные под разные CMS плагины. Например, вот страницы:

http://ogam.kayssplace.com/home/plugins/log/stats.php?8

http://www.tandempros.com/plugins/log/stats.php?8

Которые можно получить по запросам:

inurl:log/stats.php/ «Search String»

inurl:»log/stats.php?8″

inurl:»stats.php?8″

Используя данный метод, можно легко найти хорошие кеи, чего и желаю вам от всей души. Жду ваших вопросов в комментах. 🙂

Автор статьи: LoNduk.