Приветствую всех читателей RXPblog’a. В данной статье я расскажу Вам об эффективной методике добычи низкочастотного трафика, причем главным образом из Google. Чаще всего подобный траф вебмастеры сливают на различные PPC или же на некие «волшебные решения», но при правильном подходе в плане выбора ключевых слов можно добывать и более качественный нишевый траф, например, тот же фарма трафик, который затем можно сливать на партнерки. Не исключено, что кому-то из читателей методика, описанная мной в этой статье, может показаться знакомой, но однозначно для массы людей она будет в новинку, особенно с учетом скрипта, который я приложил к статье.

Приветствую всех читателей RXPblog’a. В данной статье я расскажу Вам об эффективной методике добычи низкочастотного трафика, причем главным образом из Google. Чаще всего подобный траф вебмастеры сливают на различные PPC или же на некие «волшебные решения», но при правильном подходе в плане выбора ключевых слов можно добывать и более качественный нишевый траф, например, тот же фарма трафик, который затем можно сливать на партнерки. Не исключено, что кому-то из читателей методика, описанная мной в этой статье, может показаться знакомой, но однозначно для массы людей она будет в новинку, особенно с учетом скрипта, который я приложил к статье.

Итак, в данной статье речь пойдет о добыче низкочастотного трафика главным образом со своих доменов, но возможны и методы «погорячее» в виде «пирогов». Для фармы, если использовать свои домены, данный метод не очень хорошо подходит, т.к. слишком высока конкуренция в этой нише, но если у Вас есть своя хорошая «пекарня», а значит и возможность быстрой простановки большого количества качественных ссылок, то описанный метод сработает на ура, причем и в других не менее конкурентных нишах.

Весь смысл данной статьи заключается в том, чтобы показать Вам, как привлекать трафик с Гугла на новые домены за короткий промежуток времени, что является очень весомым плюсом. Но справедливости ради стоит сказать и о главном и, пожалуй, единственном минусе данного подхода: сгенеренные вами дорвеи, сплоги и т.п. могут попасть в бан Гугла довольно быстро, но без трафа они Вас в любом случае не оставят.

Гугл — система очень большая с десятками тысяч машин в десятках датацентров, которые выкачивают интернет, строят поисковый индекс, применяют фильтры к сайтам и т.д. Содной стороны это хороший подход: Гугл может расширяться в соответствии с ростом интернета, но с другой стороны он не может быстро анализировать новые ресурсы на предмет того, дорвеи это или нет, какие ссылки стоят на ресурс, какое качество контента на ресурсе (копипаст или нет). Именно за счет этого в топы вылазят доры и живут там в общем-то недолго, но все же успевают снабдить нас трафиком. Гугл просто физически не успевает проанализировать новые страницы сразу. Есть более жесткие фильтры, есть более мягкие: к примеру, анализ контента на предмет редиректа можно проводить сразу, а вот проверить страницу на дубли уже сложнее и затратнее по ресурсам, поэтому некоторые фильтры применяются сразу, некоторые чуть позже.

Но Гугл как поисковик №1 хочет иметь у себя самую актуальную информацию, те же самые свежие и актуальные новости и т.п. За счет этого существует так называемый «бонус новичка», когда к сайту не успевают применить фильтры и он может вставать в топы без особых проблем. Потом приходит, к примеру, «Панда» и проверяет страницу на предмет копипаста, качества контента, качества ссылок и т.д., в результате чего тот или иной ресурс попадает под фильтр или уходит в бан. Этим моментом, когда фильтры к сайту еще не применены, можно и нужно пользоваться: например, сделать сайт на несколько тысяч страниц и как можно быстрее поставить на него ссылки. Очень важно, чтобы Гугл находил ваши страницы именно по ссылкам, потому что так будет куда больше шансов попасть в топ.

Всем нам известно, что в последнее время Гугл фильтрует контент, причем делает он это довольно жестко: через несколько дней сайт с неуникальным контентом может быть отправлен в песочницу или полностью забанен, поэтому нам необходимо этот контент сделать отчасти уникальным. Для того чтобы уникализировать контент, я беру основной контент, который добавляется на дорвей/сплог и немного контента с других источников, в основном с сайта http://www.digg.com/. На данном сайте очень много хорошей информации, причем само количество текста минимально в каждой новости. Я беру 5-10 новостей с Дигга и добавляю к своему контенту, в итоге получается статья + несколько упоминаний о тематике статьи в интернете, что пользователям тоже нравится. Релевантные новости с Дигга я беру с его поиска. К примеру, Вы вбиваете запрос «online insurance»: http://digg.com/search?q=online+insurance&submit= — как видите новости тематические, и найдено их довольно много. В Дигге можно найти контент практически по любому запросу. Помимо Дигга есть еще довольно много ресурсов, где можно найти подобный контент: социальные закладки, новостные сайты, обзоры и т.п. В общем много различных ресурсов в зависимости от интересующей тематики.

Теперь, когда с тем, где брать разбавляющий контент, мы определились, перейдем непосредственно к технической части и реализации наших сплогов. Для этих целей я чаще всего использую движок WordPress из-за его большого функционала и большого количества бесплатных плагинов и шаблонов.

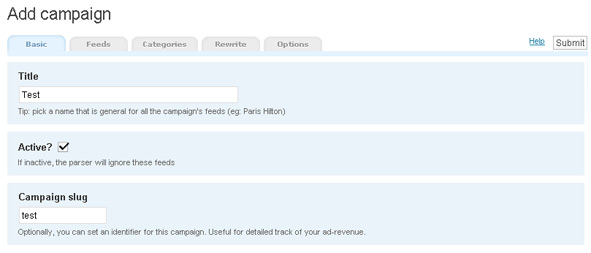

Устанавливаем WordPress на хостинг, затем скачиваем и устанавливаем плагин для граббинга RSS лент. Я использую плагин WP-o-Matic, который можно скачать здесь: http://wordpress.org/extend/plugins/wp-o-matic/. Скачиваем плагин и активируем его, затем заходим на страницу Settings → WP-o-Matic и выполняем 4 пункта, которые просит сделать плагин (более подробную информацию об этих настройках можно найти в Гугле). Затем жмем на ссылку Add campaign и заполняем необходимые поля. В подразделе Basic пишем любое название, в Feeds вводим адреса фидов, с которых парсить контент, в поле Categories выбираем категории, куда должен попадать этот контент, в подразделе Rewrite можно сделать небольшой рерайт для статей данной кампании, в поле Options можно настроить тип поста, автора и так далее. После того, как настроите кампанию, жмите кнопку Submit:

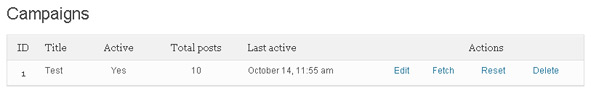

Для того чтобы спарсить фиды, необходимо зайти в раздел Campaigns и напротив нужной кампании нажать ссылку Fetch — фиды сграбятся и опубликуются:

Я не стал подробно описывать возможности данного плагина, так как статья и так получилась довольно объемная, да и информации об этом плагине в интернете предостаточно. Плагин можно запускать через крон и делать многое другое, для того чтобы узнать как это делать, смотрите документацию: http://wordpress.org/extend/plugins/wp-o-matic/.

Теперь займемся Диггом и уникализацией наших статей. Я написал небольшой плагин, который использую в своей работе, скачайте его и залейте в папку /wp-content/plugins вашего блога и поставьте права 777 на папку cache. О том как настраивать плагин, смотрите в файле readme.txt в папке с плагином. После того как поставите права на папку, активируйте плагин через админку блога в разделе Plugins. Все должно работать. Запускайте граббинг и заходите на любой пост, в итоге эти посты будут с добавлением дигг-новостей.

Теперь скажу пару слов и о других движках. Если Вы знаете PHP, то можете встроить плагин куда угодно, просто подключив файл glebgor.php и вызвав две функции: set_glebgor_title($title) — в функцию передавайте заголовок статьи и add_digg_content($content) — в функцию передавайте статью. Таким образом, можно приспособить плагин практически куда угодно — DLE, Joomla, и т.п. Если Вы желаете попробовать данную тему с фармой, то рекомендую Вам использовать CMS4SEO.

Идем дальше: теперь о раскрутке данных сплогов. Для раскрутки вам необходим Хрумер или другой сабмиттер с хорошей базой ссылок, потому что на каждый пост должна быть как минимум одна-две ссылки. Ссылки нужно сразу проставлять активно и массово, чтобы до фильтров Гугл нашел как можно больше страниц именно по внешним ссылкам, тогда статья с очень большой вероятность попадет в топ. Также можно массово покупать ссылки на биржах ссылок типа Sape, XAP и т.п., в общем везде, где можно быстро купить/поставить/снять большое количество ссылок.

Напоследок хочу сказать, что некоторые сплоги банятся довольно быстро, а некоторые живут весьма и весьма долго. Таким же образом можно работать и с различными типами трафика, но лучше всего, на мой взгляд, идет mp3, video и другой download трафик. Простые новости сами по себе дают немного трафика, поэтому делать сплоги/доры именно по ним особого смысла нет. Сплоги/дорвеи должны быть сделаны под определенную тематику с большим охватом различных кейвордов.

Желаю всем успехов в работе и побольше конвертабельного трафика! 🙂

Автор статьи: GlebGor.