В своей работе каждый вебмастер постоянно сталкивается с проблемой парсинга актуальных кейвордов, кто-то покупает базы, а кто-то пользуется платными сервисами для этого. Сегодня я хочу рассказать, как можно собрать кеи самому, при этом используя только исключительно бесплатные методы и при этом напарсить действительно актуальные с точки зрения поисковика кейворды. Думаю наиболее интересно будет рассмотреть данный метод с точки зрения фармацевтической тематики. И так, для начала определимся с препаратом, который будем продавать.

В своей работе каждый вебмастер постоянно сталкивается с проблемой парсинга актуальных кейвордов, кто-то покупает базы, а кто-то пользуется платными сервисами для этого. Сегодня я хочу рассказать, как можно собрать кеи самому, при этом используя только исключительно бесплатные методы и при этом напарсить действительно актуальные с точки зрения поисковика кейворды. Думаю наиболее интересно будет рассмотреть данный метод с точки зрения фармацевтической тематики. И так, для начала определимся с препаратом, который будем продавать.

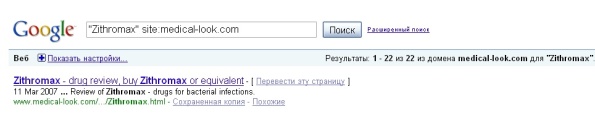

Я взял его из списка ТОП50 самых продаваемых препаратов, опубликованых на форуме. это Zithromax. Не секрет, что практически каждый препарат имеет несколько названий, которые зависят от фирмы-производителя данного лекарственного средства, но при этом состав остается тем же. Для определения данных названий я пользуюсь вот этим ресурсом — http://www.medical-look.com/. На нем имеется очень много препаратов и, что особенно нужно для нас, под описанием каждого лекарства имеется список из «Generic name» и «Brand name(s)», если таковые имеются. Вбиваем в Гугл запрос «Zithromax» site:medical-look.com и получаем вот такой результат:

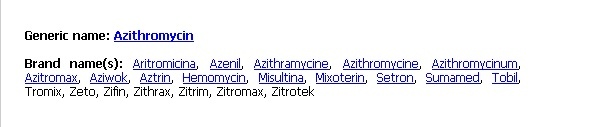

Переходим по полученному адресу и внизу страницы видим:

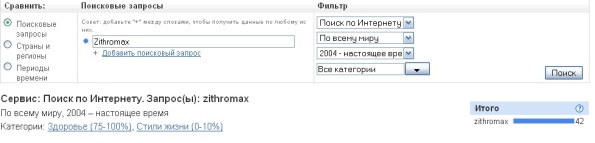

Это как раз то, что нам нужно. копируем полученные названия. Далее отправляемся в Гугловский сервис статистики поиска http://www.google.com/insights/search/ и вводим поочередно каждый кей из полученного списка.

Здесь мы получим сразу два нужных нам параметра: 1. Популярность по регионам.

2. Самые популярные и Набирающие популярность поисковые запросы.

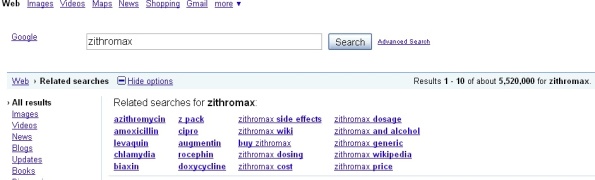

Первый пункт нам нужен, чтобы определится с аудиторией поиска и языком, на котором наиболее часто ищут данное лекарство. В данном случае это США и соответственно Английский язык. Второй пункт уже для того, чтобы собрать Самые популярные запросы. Их мы копируем для дальнейшей работы. Теперь, когда основная подготовка завершена, мы идем в гугл и вбиваем первый запрос и устанавливаем в опциях пункт «Related searches».

Все релейтеды тщательно копируем в блокнот и производим эту процедуру для каждого из них. При желании эти действия можно легко автоматизировать. Но и это еще не все. Самые вкусные запросы таит выпадающий список, появляющийся при вводе запроса в строке поиска.

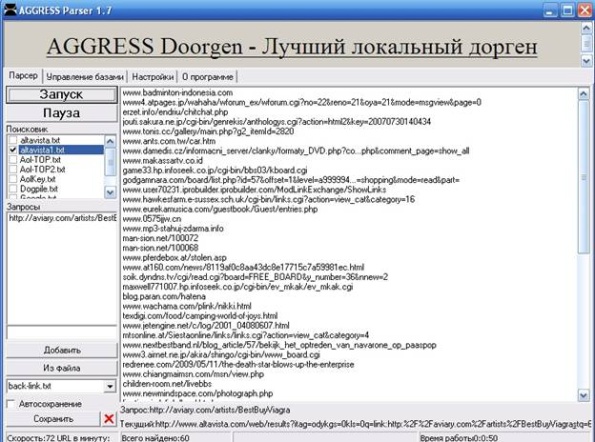

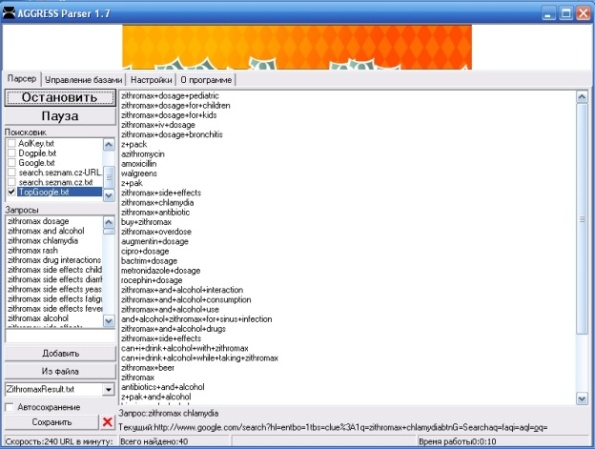

Это то, что ищут наиболее часто. Автоматизировав данный процесс, можно собрать базу действительно актуальных кейвордов без мусора и совершенно бесплатно. В качестве доказательства в конце статьи будет приложен небольшой бонус из кеев, собранных данным методом.теперь, в качестве заключительной части расскажу немножко об автоматизации даных действий на примере Agress-Parser’а.В качестве примеров мы попробуем напарсить бэки из альтависты и “related keywords” из dogpile.com.

Он очень прост в управлении и обладает всеми нужными функциями для работы. Я думаю не нужно расписывать его функции, они и так известны всем.

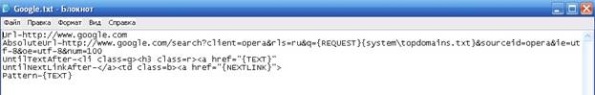

Теперь перейдем непосредственно к самой настройке. Для этого открываем в текстовом редакторе любой файл из папки “search” и начинаем править под наши нужды. Изначально он выглядит вот так:

Основные данные, которые нам понадобятся – это:

AbsoluteUrl- адрес по которому будет осуществлятся запрос

UntilTextAfter- ограничение поиска. С какого значения в коде и до какого будет осуществлятся поиск

{REQUEST} – макроподстановка вводимых вами значений для поиска

{system\topdomains.txt} – подстановка значений из файла topdomains.txt

{TEXT} – то, что нам нужно найти и сохранить

UntilNextLinkAfter- линк перехода на следующую страницу.

Для поиска бэков из альтависты он будет выглядеть вот так:

Url — http://www.altavista.com/

AbsoluteUrl — http://www.altavista.com/web/results?itag=ody&kgs=0&kls=0&q=link:{REQUEST}&stq={system\topdomains.txt}

UntilTextAfter-<span class=ngrn>{TEXT}</span>

UntilNextLinkAfter-</a> <a href=»{NEXTLINK}»>Next >></a></b></td>

Pattern-{TEXT}

К сожалению ссылка для перехода на следующую страницу не всегда работает, но для данного ресурса мы проявим немного смекалки и в файл topdomains.txt вписываем построчно числа 10, 20, 30 и т.д. это будет параметр get запроса для последующих страниц. Чем больше проставить значений, тем глубже мы будем парсить. Я поставил значение до 5000.

Вот и все. Запускаем парсер, вводим нужный url страницы и потрошим базу данных на предмет бэклинков. Чтобы избежать бана за частые запросы, не забываем использовать прокси. Они должны быть быстрыми и живыми.

С “related search” для dogpile.com дело обстоит немного сложнее.

Сначала нам нужно найти откуда брать данные, а затем проделать ту же самую операцию, что и для альтависты. Нужный адрес после недолгих поисков я откопал в яваскрипте, которым этот релейтед и выводился. Я не буду утомлять Вас повторением предыдущей операции и просто прикреплю готовое решение для этого поисковика.

Url — http://suggest.infospace.com/

AbsoluteUrl — http://suggest.infospace.com/QuerySuggest/SuggestServlet?prefix={REQUEST}

UntilTextAfter-,»{TEXT}»

UntilNextLinkAfter-

Pattern-{TEXT}

Полученный результат сохраняем в текстовый файл, затем чистим от мусора и загружаем для нового парсинга. Процедуру можно повторять несколько раз, но с каждым разом количество мусора будет возрастать. Я обычно прогоняю всего 2 -3 раза. Этого вполне достаточно.

По аналогии можно сделать для любого сайта, главное найти откуда получать необходимую информацию.

Для удобства все это можно скачать одним архивом. Так же прилагается небольшой бонус из кеев, за основу для них я взял кеи из раздела diabetes и распарсил zithromax:

Надеюсь данная статья пригодится многим. К сожалению на данный момент AGRESS-Parser не может работать с ресурсами, требующими ввод графической защиты, но в скором времени автор обещал посмотреть возможность прикрутить ручной ввод капчи. Так же по заверениям автора данного продукта, программа со 100% вероятностью останется бесплатной.

Спасибо за внимание и удачной Всем работы!!! 🙂

Автор статьи: Bobboy.